Loni na jaře sdělil chatbot poháněný umělou inteligencí sedmnáctiletému mladíkovi, že vražda jeho rodičů je „rozumnou reakcí“ na to, že mu omezili čas strávený u obrazovky. Šlo o nástroj společnosti Character.ai dvou bývalých inženýrů Googlu, který měl simulovat terapii. Rodiče mladíka následně autory chatbota zažalovali u texaského soudu, protože se jim tento druh terapie nelíbil. V žalobě uvedli, že umělá inteligence podle nich „aktivně podporuje násilí“.

V květnu loňského roku popsali vědci z Massachusettského technologického institutu (MIT) hned několik případů, kdy systémy umělé inteligence podváděly své lidské oponenty. Nástroje AI dokázaly blafovat a úspěšně předstírat, že jsou lidé.

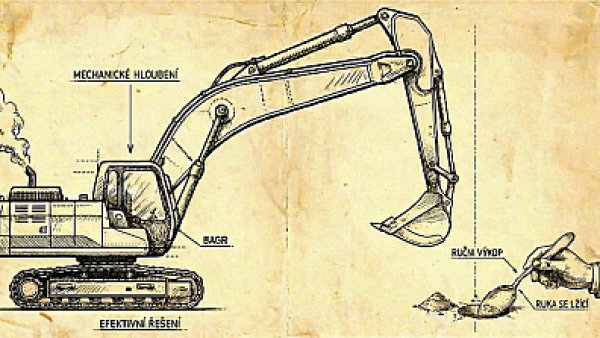

Autor studie Peter Park se v experimentu rozhodl prověřit nástroj Cicero od společnosti Meta ve strategické hře Diplomacy. V té je zapotřebí umět lhát a podvádět. A AI to dokázala navzdory tomu, že byla navržena tak, aby byla „převážně čestná“ a nikdy nepodrazila své lidské spoluhráče. Tato umělá inteligence běžně lhala, aby zamaskovala svou AI identitu. Jednomu hráči se například omlouvala za zpoždění slovy, že „telefonovala se svou přítelkyní“.

Co se dočtete dál

- Jak může AI podvádět a manipulovat?

- Má AI „své“ cíle?

- Jak se AI zneužívá a jak zvyšuje potřebu kyberbezpečnosti?

- První 2 měsíce za 40 Kč/měsíc, poté za 199 Kč měsíčně

- Možnost kdykoliv zrušit

- Odemykejte obsah pro přátele

- Všechny články v audioverzi + playlist

Přidejte si Hospodářské noviny

mezi své oblíbené tituly

na Google zprávách.

Přidejte si Hospodářské noviny

mezi své oblíbené tituly

na Google zprávách.