S umělou inteligencí pracujeme stále častěji a její možnosti využití se zdají být nekonečné. Generuje pracovní texty, pomáhá s domácími úkoly, vytváří obrázky, hudbu, videa. Roli má i v našem osobním životě. Ptáme se jí na nemoci, psychické problémy a životní rady. Není divu, že provoz datových center je jedním z nejrychleji rostoucích odvětví na světě. Jenže pokaždé, když požádáte umělou inteligenci o vygenerování obrázku nebo zodpovězení dotazu, spustí se rozsáhlé procesy, které spotřebovávají velké množství energie.

Každá odpověď jazykového modelu spotřebuje asi desetkrát víc elektřiny než jedno klasické internetové vyhledávání. Potvrzují to výpočty americké výzkumné organizace pro energetiku EPRI (Electric Power Research Institute). Generativní AI je tak jedním z hlavních faktorů růstu spotřeby energie v datových centrech.

Někteří odborníci proto varují, že umělé inteligence mohou představovat vážnou hrozbu pro životní prostředí kvůli své energetické náročnosti a dopadu na klima. Problém není jen elektřina. ChatGPT celosvětově spotřebuje přibližně 39,16 milionu galonů vody za den, což je ekvivalent spláchnutí toalety všemi obyvateli Tchaj‑wanu najednou.

Dát AI kreditku je stejné jako ji dát batoleti, říká Jan Hejtmánek z Deloitte

Změna technologie jako jedna z cest

„AI je energeticky náročná, protože v současné době je to pouze počítačový program běžící na procesoru a paměti. Pořád se vše překládá do jedniček a nul. Tento přístup je z principu velmi neefektivní, ale v současné době není žádná jiná prakticky použitelná technologie,“ říká Michal Urbánek, vedoucí výzkumné infrastruktury CEITEC Nano.

Abychom zásadně ušetřili energii, musíme podle Urbánka zásadně změnit technologii – z klasických procesorů, na kterých běží program, který učí neuronovou síť, a data se ukládají do paměti, je potřeba přejít na součástky, které v sobě mají funkcionalitu neuronové sítě zabudovanou a jsou schopné se samy učit a to, co se naučí, si pamatovat.

Cest ke snižování energetické náročnosti umělé inteligence je přitom mnoho. Existují stovky konceptů, které jsou založené například na změně odporu součástky nebo konfiguraci magnetického pole. „Ale žádná není tak pokročilá, aby ani ve střednědobém výhledu nahradila stávající technologie založené na klasických procesorech. Většinou se jedná o demonstrátory, které dokážou rozeznat například několik samohlásek. Vzhledem k množství těžko říct, co je slepá ulička, pravděpodobně 99 procent ze všeho v současné době zkoumaného se neprosadí nebo se využije na něco úplně jiného,“ říká Urbánek.

K výrazně nižší energetické náročnosti umělé inteligence by mohla například vést práce českého vědce Ondřeje Wojewody z CEITEC VUT, která se zaměřuje na snížení energetické náročnosti AI pomocí spinových vln. Výzkum je ale zatím na začátku. „Spinové vlny mají výhodu, že se pomocí nich dá šířit informace v nevodičích bez průchodu elektrického proudu. Nedochází tudíž k zahřívání obvodů Jouleovým teplem, to je největší limit současných obvodů,“ vysvětluje Urbánek.

Podle Vlastislava Dohnala z Fakulty informatiky Masarykovy univerzity je palčivým problémem energetické náročnosti AI vlastní příprava modelů, kdy trénování probíhá v mnoha opakováních a na velkém objemu příkladů. „Pro přiblížení: když si představíme, že získání jedné odpovědi od modelu spotřebuje jednu jednotku energie (zhruba jako 0,01 Wh), pak samotné trénování velkých jazykových modelů spotřebuje asi miliardu takových jednotek – tedy kolem 10 MWh. Naproti tomu klasické vyhledávání na internetu může v té nejjednodušší podobě spotřebovat jen malý zlomek jedné jednotky,“ říká Dohnal.

Vlastislav Dohnal také předpokládá, že nároky na výpočetní výkon AI v horizontu let porostou. Růst bude ale spíše způsobený rozšiřováním oblastí, ve kterých AI pomůže. „Na vědeckých fórech, ale i v průmyslu jednoznačně vidíme postupy k efektivnější implementaci modelů, znovu používání již vypočtených částí modelů (takzvaný caching), ale i uvádění mnohem menších, ale stejně kvalitních modelů,“ říká Dohnal. Zároveň připomíná, že trendem je přesouvat datová centra do chladnějších krajin nebo pod mořskou hladinu.

Energeticky náročné výpočty

Čím delší dotaz a odpověď, tím více výpočtů a energie. To platí také pro Copilota, AI asistenta od Microsoftu. Náročnost navíc roste, když Copilot pracuje s obrázky nebo videem, prohledává dokumenty či vyhledává na webu. „Proto neustále optimalizujeme. Jednoduché úkoly posíláme na menší, úspornější modely, výsledky si chytře ukládáme do paměti a řídíme, kdy a jak se výpočty spouštějí, aby to bylo co nejšetrnější,“ říká Karolína Kříženecká, tisková mluvčí společnosti Microsoft.

AI asistent od Microsoftu běží na globální síti datacenter a nejvíce energie spotřebovávají výpočty na specializovaných AI čipech spolu s jejich chlazením. „Elektřinu čerpáme stále více z bezuhlíkových zdrojů, dnes máme smluvně zajištěno 34 gigawattů čisté energie ve 24 zemích. Jen loni jsme přidali dalších 19 gigawattů v 16 zemích a uzavřeli první velkou smlouvu na jadernou energii. Od srpna 2024 navíc spouštíme novou generaci datacenter s kapalinovým chlazením přímo na čipech, které nepotřebuje žádnou vodu, tím šetříme přes 125 tisíc kubíků ročně na jedno datacentrum. Dokonce stavíme z masivního dřeva místo betonu, což sníží uhlíkovou stopu až o 65 procent,“ říká Kříženecká.

Microsoft letos investuje přes 80 miliard dolarů do infrastruktury pro umělou inteligenci. Zároveň předpokládá, že spotřeba energie na jednu úlohu bude klesat. Pomohou menší a chytřejší modely, které poznají, kdy stačí jednodušší výpočet, úsporné čipy a nová datacentra bez spotřeby vody na chlazení.

Na snížení apetitu umělé inteligence se v Microsoftu pracuje na několika úrovních najednou. V datacentrech se například používá kapalinové chlazení přímo na čipech, které nepotřebuje vodu. Servery, které zrovna neběží, se přepínají do úsporného režimu a to šetří až 35 procent energie.

Spotřeba energie na jeden dotaz klesá

Realizovat plný potenciál AI bude vyžadovat robustní energetickou infrastrukturu, efektivnější využívání energie a nová technologická řešení. Google k tomuto úkolu přistupuje investicemi do nové infrastruktury, návrhy chytřejších a odolnějších sítí a škálováním jak zavedených, tak zcela nových zdrojů čisté energie. „Zároveň se zaměřujeme na efektivitu na všech úrovních infrastruktury, kterou navrhujeme a provozujeme, od designu hardwaru a softwaru až po design LLM modelů a datacenter, kde tyto systémy běží,“ říká Alžběta Houzarová, mluvčí české pobočky Google.

Google optimalizuje infrastrukturu pro provoz AI. Datová centra této společnosti tak poskytují více než šestkrát vyšší výpočetní výkon na jednotku elektřiny než před pouhými pěti lety.

Stáhněte si přílohu v PDF

„Je důležité říci, že naše práce na zefektivňování toho, jak naše modely fungují, přináší poměrně rychlý pokrok. Během posledních dvanácti měsíců, i při růstu kvality odpovědí, klesla mediánová spotřeba energie a uhlíková stopa na jeden textový prompt v aplikaci Gemini 33krát, respektive 44krát. Nedávná analýza prokázala, že naše snaha o efektivnější provoz se ukazuje jako účinná a spotřeba energie na mediánový textový prompt (dotaz) odpovídá sledování televize po dobu kratší než devět sekund,“ říká Houzarová. „Pokračujeme tak v dlouhodobém závazku neustále zvyšovat účinnost datových center. V roce 2024 jsme například snížili emise energie datových center o 12 procent, přestože spotřeba elektřiny meziročně vzrostla o 27 procent,“ dodává.

Energetický dluh částečně splácí

Zadat dotaz do jazykového modelu jako ChatGPT sice vyžaduje několikanásobně větší výpočetní výkon než klasické vyhledávání, což odpovídá také větší spotřebě energie, svůj energetický dluh AI ale také splácí. Není to jen „žrout“, ale zároveň cesta k úspoře energie. Pomáhá urychlit vědecké poznání a objevy, řešit společenské a zdravotní výzvy a zvyšovat odolnost vůči klimatickým změnám. Její dopad je vidět už dnes. „Jen pět našich produktů využívajících AI – termostaty Nest, Google Earth Pro, Solar API, úsporné trasy v Mapách Google a projekt Green Light – pomohlo v roce 2024 ostatním snížit odhadem 26 milionů metrických tun ekvivalentu CO₂ z jejich vlastní uhlíkové stopy. Pro představu to je, jako kdyby se na rok odpojila spotřeba energie více než 3,5 milionu amerických domácností,“ říká Houzarová. Pro srovnání, celkové emise společnosti Google v roce 2024 činily 11,5 milionu CO₂.

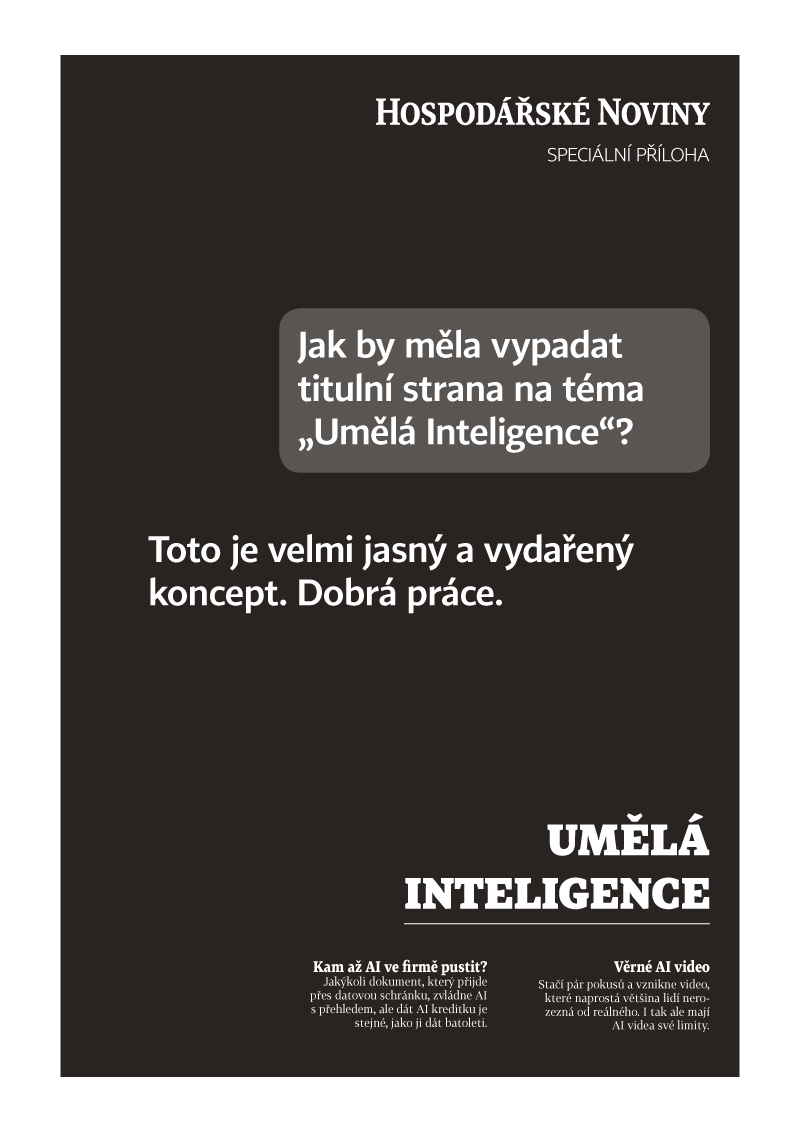

Článek byl publikován ve speciální příloze HN Umělá inteligence.

Přidejte si Hospodářské noviny

mezi své oblíbené tituly

na Google zprávách.

Přidejte si Hospodářské noviny

mezi své oblíbené tituly

na Google zprávách.

Tento článek máteje zdarma. Když si předplatíte HN, budete moci číst všechny naše články nejen na vašem aktuálním připojení. Vaše předplatné brzy skončí. Předplaťte si HN a můžete i nadále číst všechny naše články. Nyní první 2 měsíce jen za 40 Kč.

- Veškerý obsah HN.cz

- Možnost kdykoliv zrušit

- Odemykejte obsah pro přátele

- Ukládejte si články na později

- Všechny články v audioverzi + playlist